Hast du dich gefragt, wie eine Maschine ein Gedicht schreiben oder ein fotorealistisches Bild aus einer reinen Textbeschreibung erschaffen kann? Das ist dank generativer KI möglich.

Grundlagen der Generativen KI

Generative KI (Generative Artificial Intelligence) bezieht sich auf KI-Systeme, die neue, ursprüngliche Inhalte erzeugen können, die denen ähneln, auf denen sie trainiert wurden. Daten werden nicht nur interpretiert, sondern neu erschaffen. Im Kern lernen die KI-Systeme Muster und Strukturen aus existierenden Daten und generieren daraus plausible Variationen – sei es Text, Bilder, Musik, Code oder sogar Videos. Der Fokus liegt auf der Kreativität und Generierung, im Gegensatz zu reiner Analyse oder Vorhersage. Um dies besser zu verstehen, grenzen wir sie von zwei anderen prominenten KI-Arten ab.

Unterschied zu anderen KI-Modellen

Diskriminative KI

Dieses Modell lernt, Datenpunkte voneinander zu unterscheiden und sie Kategorien zuzuordnen. Es klassifiziert oder unterscheidet also bestehende Daten. Ein klassisches Beispiel ist ein Spam-Filter, der entscheidet, ob eine E-Mail «Spam» oder «kein Spam» ist. Er generiert nichts Neues, sondern trifft eine Ja/Nein-Entscheidung basierend auf gelernten Mustern.

Prädiktive KI

Diese KI trifft Vorhersagen – ganz im Sinne des lateinischen praedicere (vorhersagen) – indem sie historische Daten auswertet. Sie beantwortet die Frage “Was wird als Nächstes passieren?”. Beispiele hierfür sind Wettervorhersagen oder die Prognose von Aktienkursen. Auch hier werden keine neuen Inhalte erzeugt, sondern nur Wahrscheinlichkeiten und Schätzungen.

Generative KI

Dieses Modell lernt hingegen die zugrunde liegenden Muster und Strukturen in einem Datensatz so gut, dass es daraus völlig neue, aber plausible Beispiele generieren kann. Sie beantwortet die Frage: “Wie würde ein neues Beispiel aussehen, das zu diesen Daten passt?”.

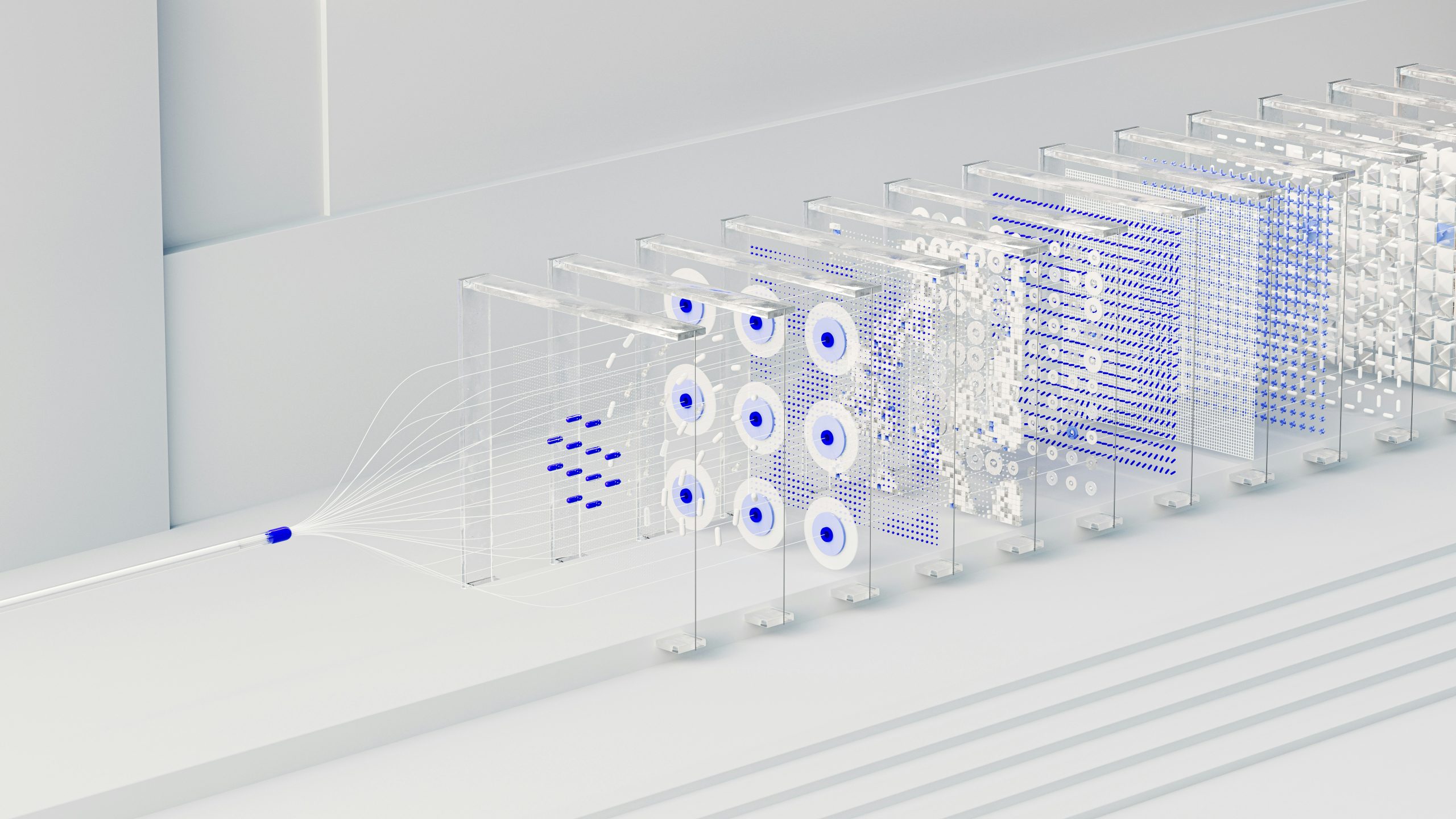

Kerntechnologien der Generativen KI

Es gibt mehrere etablierte Ansätze, die je nach Anwendungsdomäne (z. B. Text vs. Bilder) variieren. Die häufigsten sind:

Generative Adversarial Networks (GANs)

GANs bestehen aus zwei neuronalen Netzen, die gegeneinander «antreten»: dem Generator und dem Diskriminator. Stell dir einen Kunstfälscher (Generator) vor, der versucht, ein perfektes Duplikat eines Rembrandts zu malen, und einen Kunstdetektiv (Diskriminator), der echte von gefälschten Bildern unterscheiden muss.

- Der Generator erzeugt synthetische Daten. In unserem Beispiel ist es ein Duplikat, das echt wirken soll.

- Der Diskriminator bewertet (aus dem Trainingsdatensatz), ob der Rembrandt echt oder gefälscht ist.

Mit dieser Bewertung resp. diesem Feedback verbessert der Generator seine nächste Fälschung. Durch iteratives Training wird der Generator immer besser im Fälschen, und der Diskriminator wird immer besser im Erkennen. Am Ende dieses «Wettstreits» ist der Generator in der Lage, Bilder zu erzeugen, die für den Diskriminator (und oft auch für Menschen) nicht mehr vom Original zu unterscheiden sind.

Diffusionsmodelle

Diffusionsmodelle, wie sie in Stable Diffusion oder Midjourney zum Einsatz kommen, verfolgen einen anderen Ansatz. Sie erzeugen neue Daten, wie zum Beispiel Bilder oder Töne, indem sie einen schrittweisen Prozess umkehren, der aus Rauschen besteht. Stell dir also vor, du möchtest, dass eine KI ein Bild einer Katze zeichnet. Der zweistufige Prozess der Diffusion sieht entsprechend wie folgt aus.

Der Vorwärtsprozess (Rauschen hinzufügen)

Zuerst lernt das Modell, wie man ein klares Bild schrittweise in reines Rauschen (wie das «Schneegestöber» auf einem alten Fernseher) verwandelt. Es nimmt ein echtes Bild – sagen wir, eine Katze – und fügt in vielen kleinen Schritten immer mehr zufälliges Rauschen hinzu, bis vom ursprünglichen Bild nichts mehr zu erkennen ist. Diesen Vorgang wiederholt das Modell tausendfach, um ein tiefes Verständnis dafür zu entwickeln, wie sich ein Bild in Rauschen auflöst.

Der Rückwärtsprozess (Rauschen entfernen)

Das ist der eigentliche kreative Teil. Das Modell lernt, diesen Prozess umzukehren. Es startet mit einem Bild, das nur aus zufälligem Rauschen besteht, und entfernt dann schrittweise dieses Rauschen, bis ein klares, neues Bild entsteht. Da es im Training gelernt hat, wie Rauschen zu einem Bild hinzugefügt wird, kann es nun vorhersagen, wie das Rauschen entfernt werden muss, um ein glaubwürdiges Bild zu enthüllen. Wenn du ihm sagst “erschaffe eine Katze”, leitet es diesen Entrauschungsprozess so, dass am Ende das Bild einer Katze erscheint, die es noch nie zuvor gesehen hat.

Transformer-Architekturen (GPT)

Transformer-Modelle sind die Grundlage von generativen Sprachmodellen wie GPT (Generative Pre-trained Transformer). Diese Modelle erzeugen neuen Text, indem sie lernen, wie Sprache funktioniert.

Um zu verstehen, wie diese Modelle Sprache erlernen und darauf basierend neue Inhalte erstellen, werfen wir einen Blick auf ihre inneren Mechanismen. Der Prozess beginnt mit der Art und Weise, wie sie Text grundlegend verarbeiten, und endet mit der Methode, mit der sie Wortbedeutungen im Kontext abwägen. Dies führt uns direkt zu den folgenden Kernfragen:

Was sind Tokens?

Text wird in kleine Bausteine zerlegt, die «Tokens» heissen. Das können ganze Wörter, Wortteile oder einzelne Zeichen sein. So kann die KI den Text wie ein Puzzle verarbeiten.

Was ist Self-Attention?

Das ist wie ein Radar, das das Modell für jedes Token aktiviert. Es schaut sich alle anderen Tokens im Satz an und entscheidet: “Welche sind wichtig für diesen einen?” Dadurch lernt die KI tiefe Zusammenhänge im Text, ohne alles der Reihe nach zu prüfen.

Wie generiert es Inhalte?

Die KI prognostiziert ein Wort (oder Token) nach dem anderen, basierend auf dem, was schon da ist. So entsteht ein fliessender, sinnvoller Text – z. B. fängt sie mit “Erzähl mir eine Geschichte” an und baut sie Wort für Wort aus, ohne den Faden zu verlieren.

Training der Generativen KI

Der Weg zu leistungsstarken generativen Sprachmodellen ist mit einem enormen Bedarf an Daten und Rechenleistung verbunden. Das Training dieser Modelle ist so ressourcenintensiv, dass es die Grenzen heutiger Supercomputer auslotet und erhebliche ökologische Fragen aufwirft. Diese Herausforderung treibt die Forschung an, nachhaltigere und effizientere Methoden zu entwickeln.

Datenmengen und Rechenressourcen

Generative Modelle werden meist unüberwacht oder selbstüberwacht trainiert. Sie analysieren riesige und vielfältige Datensätze und sind entsprechend datenhungrig.

- Sprachmodelle wie GPT-5 werden mit enorm grossen Datensätzen aus dem Internet trainiert, darunter ein grosser Teil des öffentlich zugänglichen Internets (z. B. Common Crawl), Bücher und Wikipedia. Dabei handelt es sich um Hunderte Terabyte an Daten.

- Bildmodelle werden mit Milliarden von Bild-Text-Paaren trainiert (z. B. der LAION-5B-Datensatz).

Für das Training selbst sind Tausende spezialisierter Prozessoren (GPUs) erforderlich, die oft über mehrere Monate hinweg ununterbrochen laufen. So wurden für das Training von Apertus auf dem Alps-Supercomputer des CSCS in Lugano bspw. insgesamt etwa 6 Millionen GPU-Stunden benötigt. Der Energieverbrauch belief sich auf rund 5 Gigawattstunden (GWh). Damit könnte man rund 1’200 bis 1’400 Familienhaushalte ein ganzes Jahr mit Strom versorgen.

Anstatt nur darüber zu lesen, kannst du das Ergebnis nun direkt und unkompliziert nutzen. Über unsere Pantobot KI-Plattform bieten wir dir kostenlosen Chat-Zugriff auf Apertus. Probiere es jetzt aus!